S/4HANA-Integration mit Public Clouds & Data Lakes

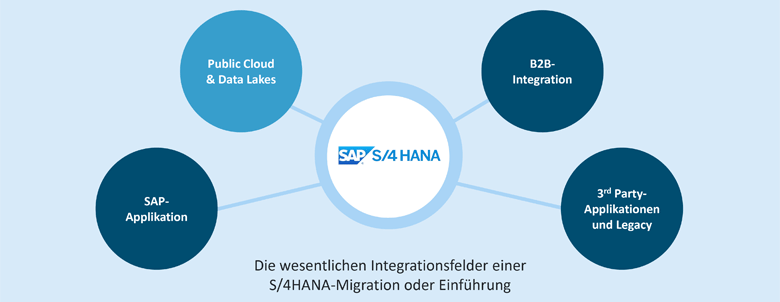

Bei der Einführung von SAP S/4HANA sind die zu integrierenden Endpunkte oft ganz verschieden und hängen von Faktoren wie der Branche, der individuellen IT-Landschaft und ganz allgemein von der Digitalisierungs- und Cloud-Strategie eines Unternehmens ab. Wir behandeln in einer aktuellen Blogserie vier Integrationsfelder im Integrationsraum SAP S/4HANA:

- 3rd Party-Applikationen und Legacy-Systeme

- B2B-Integration

- Public Cloud und Data Lakes

- SAP-Applikationen

Dieser Blogbeitrag thematisiert die SAP S/4HANA-Integration mit Public Clouds und Data Lakes.

S/4HANA-Integration mit Public Clouds und Data Lakes – höchste Datenverfügbarkeit für die Informationsgewinnung

Die Bedeutung der Integration von Public Clouds ist parallel mit ihrer zunehmenden Nutzung durch Unternehmen gestiegen. Im Kontext dieses Integrationsfelds liegt der Schwerpunkt nicht auf der Integration von Applikationen und Systemen, die als betriebswirtschaftliche Anwendungen in einer Public Cloud, etwa einem Hyperscaler, betrieben werden. Das wesentliche und neue Element ist vielmehr die Nutzung der Möglichkeiten und Service-Angebote von Hyperscale-Environments für den Aufbau von Data Lakes und die Nutzung von dort verfügbaren Werkzeugen für Analytics/BI, Machine Learning (ML), IoT und Artificial Intelligence (AI).

Vor wenigen Jahren rückte das Thema Big Data immer mehr in den Fokus. Open Source Lösungen wie Apache Spark, Apache Hadoop und Apache HBase erregten höchste Aufmerksamkeit. Sie eröffneten Unternehmen bislang ungeahnte Möglichkeiten, Big Data in Informationen umzuwandeln. Jeder konnte nun ein wenig wie Google werden, denn Daten existieren in jedem Unternehmen in Hülle und Fülle.

Die Ablage und Verwaltung von Daten in einfachen Strukturen war die Grundlage: Datenmodelle mussten nicht mehr wie bei herkömmlichen Datenbanken oder Data Warehouses vorab definiert werden, sondern sie wurden erst im Moment des Zugriffs festgelegt. Einfachheit und Flexibilität ermöglichten es somit, die Massendaten jederzeit beliebig zu analysieren – und immer wieder „neue Fragen“ im Sinne der Analyse an dieselbe Datengrundlage zu richten. Ein spannendes Anwendungsbeispiel dafür, was sich etwa mit gesammelten Sensordaten von Bundes-Autobahnen erzielen lässt, ist in unserem Beitrag Big Data, IoT und die SEEBURGER AG beschrieben.

Parallel wurden Begriffe wie predictive maintenance en vogue – basierend auf der Verfügbarkeit von beispielsweise Sensordaten im Kontext von IoT. Heute sind es unter anderem Mobility-Daten, die im Zentrum der Aufmerksamkeit stehen. Ein moderner PKW produziert 25 Gigabyte an Daten pro Stunde, ein autonom fahrendes Fahrzeug kommt auf 4.000 Gigabyte am Tag. Obwohl viele dieser Daten flüchtig sind, stellt sich die Frage, was man aus diesen Daten machen kann, welche Muster man erkennt und welche Voraussagen möglich werden.

S/4HANA-Integration mit Public Clouds und Data Lakes – Wie bekommen Unternehmen die Datenflüsse in den Griff?

Schnell stießen und stoßen Unternehmen allerdings auf zwei zentrale Hürden:

- Die Masse der Daten: Wie kann ein einzelnes Unternehmen eine skalierbare und effiziente Infrastruktur für die Ablage und Verwaltung der Massen-Daten vorhalten?

- Die Anforderungen im Aufsatz und der Verwaltung der Open Source-Lösungen, um die gewünschten Informationen aus der Analyse der Daten zu erhalten, erfordern Expertenwissen.

Es ist nicht weiter verwunderlich, dass sich Hyperscaler des Themas sofort angenommen haben. Die effiziente Bereitstellung skalierender IT-Infrastrukturen – etwa für den Aufbau von Data Lakes – ist die Kerndomäne von Public Clouds, die Bereitstellung der Analyse-Werkzeuge als Service-Angebot befriedigt die Nachfrage nach Mehrwertdiensten. Einen guten Überblick bietet immer noch dieser Artikel, der am Beispiel von AWS, AZURE, GCP einen Einstieg und Überblick über die Cloud Data Services dieser Hyperscaler bietet.

Der Abbau der beiden genannten Hürden hat allerdings neue Fragen aufgeworfen:

- Wie kommen die Daten aber nun in den Data Lake in der Public Cloud?

- Wie werden zusätzlich bidirektionale Datenflüsse bewältigt?

Genau diese Fragen werden im Integrationsfeld Public Clouds und Data Lakes mit einer hybriden Integrationsplattform gelöst – und SAP S/4HANA ist hierbei eine der interessanten Datenquellen. Selbstverständlich muss eine solche Plattform nicht nur S/4HANA integrieren können, sondern beliebige andere Datenquellen und 3rd Party Applikationen oder Messaging-Verfahren wie JMS oder KAFKA unterstützen.

S/4HANA-Integration mit Public Clouds und Data Lakes – Multi-Cloud- bzw. Hybrid-Cloud-Strategien lösen Ihre Integrationsanforderungen

Die erforderlichen Integrationsstile und Technologien für die Anbindung von Data Lakes in Public Clouds reichen von eventbasierten Szenarien, über JMS, File, HDFS, die Anbindung von Blob Storage Diensten, NAS/NFT bis hin zu Streaming/KAFKA und Kommunikationsstandards in IoT und IIoT wie MQTT. Einen Überblick verschaffen hier die Kategorien ‘Public Cloud Access Technology’ und ‘Databases and Data Storage’ auf unserer Konnektoren-Seite.

Diese Möglichkeiten kommen auch dann zum Einsatz, wenn Unternehmen im Kontext hybrider IT-Infrastrukturen Multi-Cloud-Umgebungen aufbauen. Im engeren Sinne bedeutet dies die Nutzung mehrerer Public Cloud-Angebote. Im weiteren Sinne beschreibt es den Umstand, dass die gesamte IT-Infrastruktur eine Kombination mehrerer (interner oder gehosteter) Private und Public Cloud Lösungen ist und cloudbasierte Applikationen oder Services genutzt werden – und dies erfordert hybride Cloud Integration. Somit verfolgt nahezu jedes SAP S/4HANA-Anwenderunternehmen eine Multi-Cloud-Strategie – und steht somit vor allen resultierenden Integrationsanforderungen:

- Multi-Cloud-Integration zwischen mehreren Public Clouds/Hyperscalern,

- Hybrid-Cloud-Integration zwischen Private Clouds und Public Clouds/Hyperscalern.

Die Beherrschung von Bulk-Daten ist in diesem Kontext eine zentrale Güte der auszuwählenden Integrationsplattform. Reine iPaaS-Angebote überraschen zudem oft mit einer Kostenexplosion, wenn Massendaten darüber integriert werden – bedingt durch ihr nutzungsabhängiges Preismodell. Eine gute Lösung stellen dagegen hybride Integrationsplattformen dar, die in jeder beliebigen Cloud und On-Premises betrieben werden: sie ermöglichen es, die Effizienz der Integrationsleistungen mit kalkulierbaren und beherrschbaren Kosten zu kombinieren.

Informieren Sie sich über die SEEBURGER – SAP S/4 HANA Integrations-Lösungen und lesen Sie auch unsere weiteren Blogbeiträge zu all den Aspekten, die bei dieser monumentalen Aufgabe zu berücksichtigen sind. Denn eines ist sicher: S/4HANA-Integration ist Expertensache.

Vielen Dank für Ihre Nachricht

Wir freuen uns über Ihr Interesse an SEEBURGER

Haben Sie Fragen oder Anmerkungen?

Wir freuen uns hier über Ihre Nachricht.

Ein Beitrag von: Thomas Kamper

Thomas Kamper, SVP Strategic Product Management, ist verantwortlich für strategische Produktinitiativen im Zusammenhang mit allen Business Integrationstechnologien und -lösungen von SEEBURGER. Der Schwerpunkt liegt derzeit auf API-Lösungen und Big Data. Er ist auch für Lösungen verantwortlich, die es Unternehmen ermöglichen, Herausforderungen hinsichtlich Transparenz und Kontrolle zu meistern, wenn ihr Tagesgeschäft auf die reibungslose Ausführung digitalisierter Geschäftsprozesse angewiesen ist. Er ist im Dezember 2017 wieder bei SEEBURGER eingetreten. Zuvor war er als Interims-Manager und Business Advisor tätig. Er unterstützte dabei viele Jahre das C-Level von Software- und Cloud-Service-Anbietern, ihre strategischen Produktinitiativen erfolgreich umzusetzen.