Automatische KI-Bildanalyse – Experimente mit multimodalen Maschinenlernen-Modellen

Maschinen können lernen. Hierfür müssen sie, genau wie Menschen auch, für die vorgesehene Aufgabe trainiert werden. SEEBURGER fördert in Kooperation mit dem Hector-Seminar hochbegabte Schülerinnen und Schüler im MINT-Bereich. Die von SEEBURGER ausgeschriebenen Projekte drehen sich um Experimente mit multimodalen Maschinenlernen-Modellen (ML-Modelle) zur automatischen KI-Bildanalyse. Erhalten Sie Einblicke in die SEEBURGER-Forschung und erfahren Sie, wie die hochbegabten Schülerinnen und Schüler lernen, mit Tensorflow-Modellen zu experimentieren, diese in Szenarien zu integrieren und eine Dialoganwendung zu erstellen.

Comic-Serien wie „Arrow“ und „Flash“ beweisen es: übermenschliche Fähigkeiten sind zwar sehr nützlich, um die Menschheit zu retten. Doch ohne die Programmier- und Forschungstalente ihrer Teams im Hintergrund, die so richtig was in der Birne haben, hätten die Helden kaum eine Chance gegen das Böse. Ergo – Superheroes brauchen Leute mit Verstand, die ihnen ständig den Allerwertesten retten.

Natürlich müssen auch die Kids mit Grips im Rahmen wissenschaftlicher Projekten zunächst einmal lernen, mit welchen Mitteln sie ihre Talente in sinnvolle Bahnen lenken können. In Kooperation mit dem Hector-Seminar bietet SEEBURGER hierfür Projekte zur Förderung hochbegabter Schüler aus dem MINT-Bereich an.

Das Projekt zur automatischen KI-Bildanalyse – Experimente mit multimodalen Maschinenlernen-Modellen

In den derzeit bei SEEBURGER laufenden Projekten lernen jeweils zwei junge Talente, die sich für diese spezielle Förderung qualifiziert haben, Maschinen anhand multimodaler Modelle auf die Erkennung und Klassifizierung von Bildinhalten zu trainieren. Körper- und Handgesten, das Zeigen von Karten mit einer Ziffer, ein bestimmter Ort, die Anzahl von Personen in einer Situation oder ihr Abstand zueinander sind Ereignisse, die bei der automatischen Verarbeitung einer Folge von Bildern relevant sein können – so zum Beispiel in Pandemiezeiten wie diesen, für die Berechnung von Abständen zwischen zwei Personen. Auch die Möglichkeit zu erkennen, ob Personen eine Maske tragen, und dies auf korrekte Art und Weise, kann derzeit sehr nützlich sein.

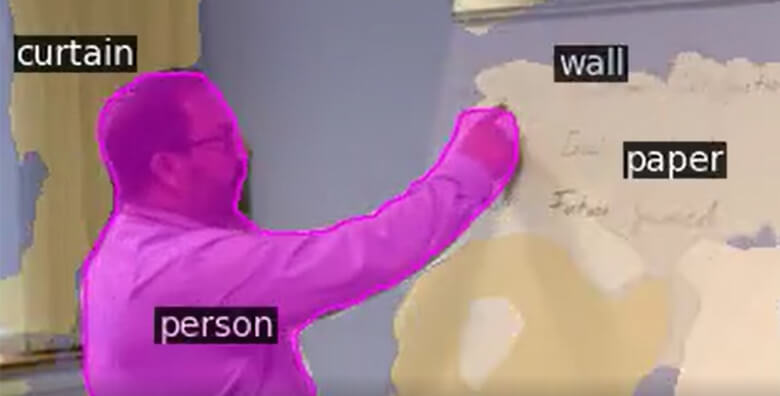

Möglich wird dies durch trainierte ML-Modelle, die insbesondere frei zur Verfügung stehen und auch in Browser- und eingebettete IoT-Anwendungen integriert werden können. Mit ML-Modellen können zudem beispielsweise Personen, Tiere, Objekte und Körperstellungen in Bildern, Videos und Livestreams erkannt werden.

Hierfür war es sehr hilfreich (jedoch nicht Voraussetzung), dass die Teilnehmenden schon erste Programmiererfahrung mit Python oder JavaScript hatten. So machte das Projekt von Anfang an gleich richtig Spaß. Und sie bekamen auch richtig cooles „Spielzeug“ zur Verfügung gestellt:

Die konkrete Aufgabenstellung

Mit Einplatinenrechnern von Nvidia und Google sollte im ersten Projekt, das seit September 2020 bis Juli 2021 läuft, mit verschiedenen Tensorflow-Modellen für unterschiedliche Modalitäten experimentiert und Erfahrung gesammelt werden. Danach waren anhand von Szenarien Ideen zu entwickeln, wie man diese einsetzen kann. Hierbei konnten mehrere Anwendungen skizziert werden, die diese z. B. in Dialogen und Aktionen im Arbeitsalltag, in Produktionsumgebungen, in Logistikzentren oder bei der Interaktion mit Software integrieren. Inspiration lieferten hierbei z. B. Youtube-Videos, Filme, Spiele oder Literatur.

Im nächsten Schritt sollte man sich zunächst auf ein Modell konzentrieren, den Sourcecode verstehen und verändern. Zum Beispiel konnte man hier eine Geste ausgeben, die für eine Situation in einem der Szenarien relevant ist.

Im Ergebnis sollte mindestens ein zusammenhängender Dialog mit mehreren Schritten aus einem der Szenarien praktisch gezeigt werden.

In einem weiterführenden Projekt, ab September 2021 bis Juli 2022, wird es darum gehen, mit mehreren vorhandenen Maschinenlernen-Modellen zu experimentieren und damit ausgewählte Videostreams möglichst automatisch zu beschreiben. Auch hier soll zunächst mit verschiedenen trainierten Maschinenlernen-Modellen in JupyterLab Erfahrung gesammelt werden. Hierbei können verschiedene Youtube-Livestreams sowie die Webcam und die Stereokamera der Einplatinenrechner verwendet werden.

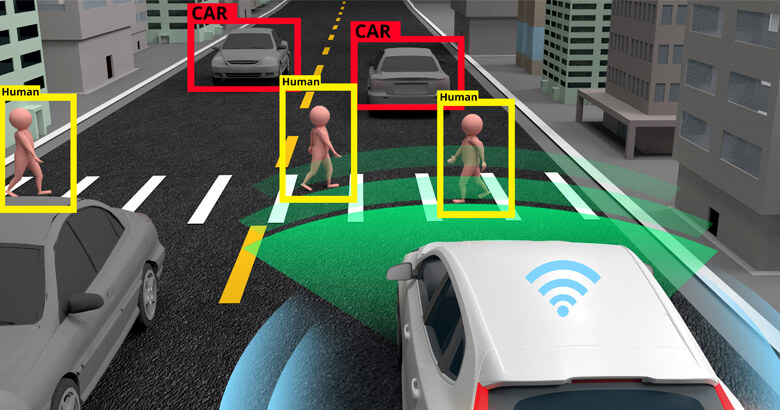

Danach sollen ausgewählte Livestreams oder Bilder mit den Modellen möglichst automatisch beschrieben werden. Dies kann das Erkennen und Zählen von PKWs, LKWs, Personen, Tieren und Objekten enthalten. Was sind Gemeinsamkeiten und Unterschiede? Was ist gut zu erkennen, was nur schlecht? Kann man einzelne Gesichter und Körperstellungen erkennen? Gibt es Regelmäßigkeiten? Kann man Größen, Abstände, Geschwindigkeiten und Bewegungsrichtungen berechnen?

Corona-bedingt durften die Teilnehmenden das Equipment zum Experimentieren mit nach Hause nehmen. Alle drei Wochen fand per Teams ein Online-Meeting mit der SEEBURGER-Abteilung für Forschung und Entwicklung statt, um die Fortschritte und Ergebnisse zu besprechen.

Die jungen Talente konnten in dieser Zeit wichtige Erkenntnisse gewinnen, wie multimodale Maschinenlernen-Modelle für die automatische Erkennung und Beschreibung von Bildern und Videos trainiert werden können. Gleichzeitig haben sie wertvolle Erfahrung im Umgang mit der erforderlichen Hard- und Software gesammelt.

Der Nutzen von KI-Bildanalyse ist groß. In der Gesundheitsversorgung wird die automatische KI-Bildanalyse für die Auswertung von Röntgenbildern erfolgreich eingesetzt. Soziale Netzwerke, Online-Shops und Online-Portale wie airbnb setzen die Technologie für die Klassifizierung von neu eingestellten Bildern zur Verbesserung der Bildersuche ein. Zum Zwecke der Kartierung von Bauarbeiten und Landschaftsveränderungen werden Satellitenaufnahmen automatisch ausgewertet.

Klar, es gibt immer zwei Seiten einer Medaille und das amerikanische Unternehmen Clearview AI, das Milliarden Fotos aus dem Netz zusammengeklaubt und daraus eine Biometrie-Datenbank für Behörden gemacht hat, zeigt uns aktuell deren Rückseite. Jeder Batman hat wohl seinen Joker. Daher ist es umso wichtiger, junge Talente zu fördern, damit sie lernen, diese kreativ und sinnvoll einzusetzen, um vielleicht eines Tages mit ihren Fähigkeiten einen wertvollen Beitrag leisten zu können. Es muss ja nicht immer gleich um die Rettung der Menschheit gehen. Aber, wer weiß?

Über das Hector-Seminar

Das Hector-Seminar fördert hochbegabte Schülerinnen und Schüler in der Region Nordbaden. In wöchentlichen Sitzungen arbeiten und forschen diese an Fragen und Problemen aus dem MINT-Bereich. Voraussetzung für die Aufnahme in das Hector-Seminar ist die erfolgreiche Teilnahme an dem zentralen Testverfahren, das an ausgewählten Gymnasien in der Region Nordbaden durchgeführt wird. Die Förderung beginnt in Klasse 6 und endet im Abiturjahr.

Die Kooperation mit SEEBURGER begann im September 2020 mit den hier beschriebenen Projekten.

Vielen Dank für Ihre Nachricht

Wir freuen uns über Ihr Interesse an SEEBURGER

Haben Sie Fragen oder Anmerkungen?

Wir freuen uns hier über Ihre Nachricht.

Ein Beitrag von: Dr. Johannes Strassner

Dr. Johannes Strassner ist Leiter der Forschung und verantwortlich für die anwendungsorientierte Forschung zur Innovation der SEEBURGER Business Integration Technologien und Lösungen. Sein aktueller Schwerpunkt liegt auf Maschinellem Lernen, Big Data, API, Blockchain und IoT. Johannes Strassner promovierte an der Universität Koblenz-Landau für seine Arbeit über 'Parametrisierbare Menschmodelle für Dialogumgebungen'. Nach Forschungsaktivitäten am Massachusetts Institute of Technology und der Fraunhofer-Gesellschaft kam er 2011 zu SEEBURGER.